لندن: كثيراً ما لا نكون نحن وحدنا الذين نقرر طريقة حياتنا بل يتدخل آخرون في تحديدها. فإن آخرين هم الذين يقررون إن كنتَ صالحاً للتوظيف أو مؤهلاً للحصول على قرض أو مقبولاً لدخول الجامعة أو انك مرتكب جريمة.

وتقليدياً، فإن هؤلاء الآخرين هم بشر قد يكونون أرباب عمل أو مدراء بنوك أو أعضاء مجلس قبول في جامعة أو قضاة، نتوقع منهم جميعاً ان يتخذوا قرارات عادلة، لأن قراراتهم يمكن ان تكون مصيرية في حياتنا.

وبديهي ان صنع القرارات الاعتباطية والجائرة ليس ظاهرة جديدة أو عصية على الروبوتات.

الآن يحدث تغيير جذري في مجال صنع القرار بتأثير تكنولوجيا المعلومات الكبرى والغورثيمات. فإن الكميات الهائلة من المعلومات التي تُجمع في قواعد بيانية وما يُسمى تقنيات تعليم الآلة تتيح أتمتة أعداد كبيرة من القرارات.

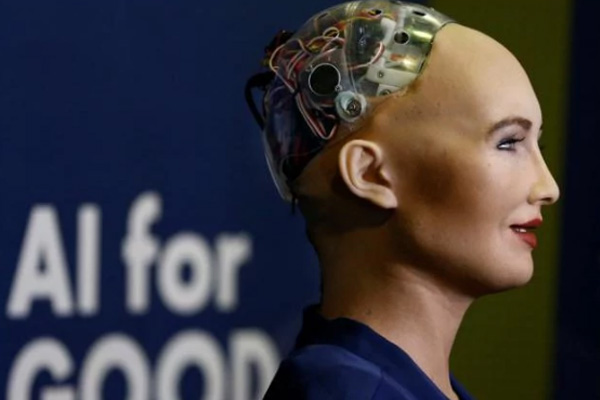

ويمكن ان تكون الغوريثمات أو الذكاء الاصطناعي أعلى كفاءة وأرخص كلفة وأدق من البشر، إذا أُحسن تصميمها. لذا ليس من المستغرب ان نستعيض بصورة متزايدة عن صانعي القرارات البشر بالغوريثمات تصنع القرارات، وهي التي تقرر الآن توظيفنا أو تسريحنا من الوظيفة أو الحكم علينا بالسجن.

ولكن الغوريثمات كثيرًا ما تكون شديدة التعقيد والابهام، من الصعب تمحيص عملياتها ويمكن ان تتخذ قرارات منحازة وتمييزية. وأفادت تقارير أن شركة فايسبوك أوقفت تجربة، لأن اثنين من الروبوتات بدءآ يتواصلان مع أحدهما الآخر بلغة لا يفهمها غيرهما.

الواقع أكثر تعقيداً ولكن الواقعة تثير سؤالاً بالغ الأهمية هو إذا كان الذكاء الاصطناعي قادراً على التفكير بطرق لا نفهمها، فإلى أي مدى يمكن ان يُحاسب على افعاله؟

أعدّت "إيلاف" هذا التقرير بتصرف عن "الديلي تلغراف". الأصل منشور على الرابط التالي:

http://www.telegraph.co.uk/technology/2017/08/01/algorithms-future-must-not-allow-become-shield-injustice/

التعليقات