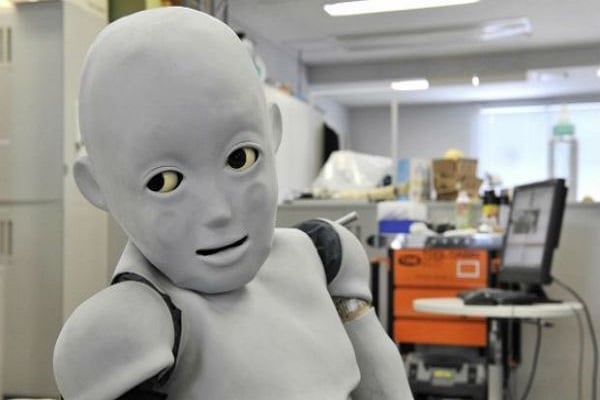

أطلق علماء كبار من أمثال ستيفن هوكينغ وإيلون ماسك مجموعة تحذيرات بشأن التهديدات المحتملة التي يمثلها الذكاء الاصطناعي، وهي التحذيرات التي جاء ليؤكد عليها فريق من الباحثين بتأكيدهم أنهم لن يتمكنوا مطلقاً من برمجة الروبوتات لكي تتمكن من التفريق بين الصواب والخطأ بغض النظر عما يقومون بتعليمه لها.

شدد& العلماء على أن الروبوتات لا تمتلك القدرة على تحديد ما هو "صواب" لكي تفعله في مواقف بعينها، بل لا يمكن توقع ما قد يبدر منها في ردود أفعالها حين تتعرض لبعض المواقف التي ترقى لكونها معضلات أخلاقية غير محسوبة.

وفي بحث جديد قاموا بإعداده تحت عنوان " الحدود المنطقية لأخلاقيات الماكينة مع التداعيات الخاصة بالأسلحة الفتاكة المستقلة"، ناقش هؤلاء الباحثون الذين يعملون في جامعة دارمشتات للتكنولوجيا في ألمانيا الاستخدام الوشيك للأسلحة المستقلة.

وقال الباحثون في هذا السياق إن الأسلحة المستقلة الفتاكة تبشر بإحداث ثورة في دنيا الحروب، وأنها ظهرت لتثير العديد من الأسئلة الأخلاقية والقانونية. وبينما سبق أن اقترحت أفكار تتحدث عن أن الروبوتات يمكن أن تزود بـ "بوصلة أخلاقية"، مثلما جاء في اتفاقيات جنيف، فقد أوضح الباحثون أن ذلك الأمر لن يكون كافياً.

وأوردت صحيفة الدايلي ميل البريطانية بهذا الخصوص عن مايكل بايرن، أحد الباحثين المشاركين في تلك الدراسة البحثية الجديدة، قوله :" ما يمكننا قوله بشأن الذكاء الاصطناعي هو أن الخوارزميات تفعل أشياء غير متوقعة، وتوجد ثمة مشاكل بالبرامج".

وتابع بايرن حديثه بالقول :" فإحدى الخوارزميات التي تمت برمجتها لكي تفعل الشيء الصواب ربما تقوم بفعل الشيء الخطأ". وهو ما جعل الباحثين يؤكدون على حقيقة أن الذكاء الاصطناعي سيقترن دوماً بحالة من عدم القدرة على التنبؤ، بغض النظر عن الجهد الذي يبذله معها الخبراء والباحثون من أجل برمجتها بصورة تامة.

&

&

&

.jpg)

التعليقات