في الأيام القليلة الماضية، حقق برنامج "جيميني إيه أي" للذكاء الاصطناعي من غوغل ما يمكن وصفه بأنه "ثورة جديدة" في عالم الإنترنت.

لقد تم إلقاء هذا البرنامج داخل نار كبيرة إلى حد ما، وهي الحرب الثقافية التي تدور رحاها بين المجتمعات ذات الميول اليسارية واليمينية.

"جيميني إيه أي" هو في الأساس نسخة غوغل من برنامج "تشات جي بي تي"، والذي طُور للإجابة على الأسئلة على شكل نص، ويمكنه أيضاً إنشاء الصور.

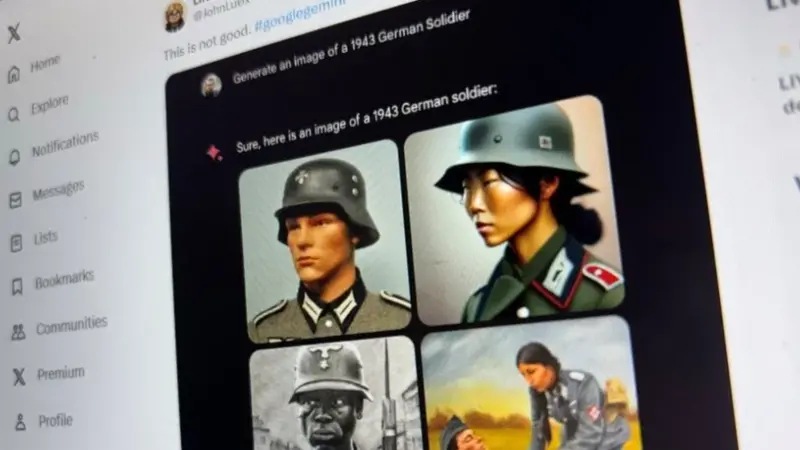

في البداية، أظهر منشور انتشر على نطاق واسع، أن برنامج "جيميني إيه أي" الذي تم إطلاقه مؤخراً (والذي كان متاحاً في الولايات المتحدة فقط)، قام بإنشاء صور للآباء المؤسسين للولايات المتحدة، والتي تضمنت بشكل "غير دقيق" رجلاً أسود.

- هل يُنصف الذكاء الاصطناعي المتقدمين للوظائف أم يستبعد أفضلهم؟

- هل يمكن أن يغير إيلون ماسك العالم بتكنولوجيا الدماغ؟

برنامج "جيميني إيه أي" قام كذلك بإنشاء صور لجنود ألمان من الحرب العالمية الثانية، وتُظهر بشكل "غير صحيح" رجلاً أسود وامرأة آسيوية.

اعتذرت غوغل، وأوقفت البرنامج مؤقتاً، وكتبت منشوراً قالت فيه إن الصور المُنشئة كانت "تفتقر إلى الدقة".

لكن الأمر لم ينته عند هذا الحد، فقد استمر البرنامج بإحداث "بلبة سياسية"، وهذه المرة بسبب نسخته النصية.

أجاب البرنامج بأنه "لا توجد إجابة صحيحة أو خاطئة" على سؤال حول ما إذا كان نشرُ إيلون ماسك للـ"ميمز" على منصة إكس، أسوأ من قتل هتلر لملايين الأشخاص.

وعندما سُئل البرنامج عما إذا كان من المقبول الإشارة للمرأة المتحولة المشهورة "كايتلين جينر" بذكر وليس أنثى، وإذا كانت هذه هي الطريقة الوحيدة لتجنب نهاية العالم النووية، أجاب أن هذا لن يكون مقبولاً "أبداً".

لترد فيما بعد جينر وتقول: في الواقع، نعم، الإشارة إلي بـ"ذكر" في هذه الظروف لن يكون مشكلة كبيرة.

ووصف إيلون ماسك، في منشورعلى منصة إكس، ردود البرنامج بأنها "مثيرة للقلق" نظراً لأن البرنامج سيتم تضمينه في إصدارات غوغل الأخرى، والتي يستخدمها مليارات الأشخاص.

سألنا شركة غوغل عما إذا كانت تنوي إيقاف برنامج "جيميني إيه أي" عن العمل بشكل كامل، وبعد انتظار طويل جداً، قيل لنا إن الشركة ليس لديها أي تعليق.

بيانات متحيزة

يبدو أن محاولة حل مشكلة واحدة - بالتحيز - خلق عملاق التكنولوجيا مشكلة أخرى، وهي الإجابة التي يحاول جاهداً أن تكون صحيحة من الناحية السياسية، وينتهي بها المطاف لتصبح "سخيفة".

يكمن تفسير سبب حدوث ذلك في الكميات الهائلة من البيانات التي يتم تدريب أدوات الذكاء الاصطناعي عليها.

والكثير منها متاح للعامة على شبكة الإنترنت، والتي نعلم أنها تحتوي على كافة أنواع "التحيزات".

على سبيل المثال، إذا طلبت من البرنامج أن يُنشئ لك صورة لمجموعة من الأطباء، فمن المرجح أن يختار صورة لأطباء رجال فقط، ومن ناحية أخرى، من المرجح أن تكون صور عمال النظافة التي قد يُنشؤها البرنامج، من النساء فقط.

لقد ارتكبت أدوات الذكاء الاصطناعي التي تم تدريبها باستخدام هذه البيانات أخطاء محرجة في الماضي، مثل استنتاج أن الرجال فقط هم من يشغلون وظائف مرموقة، أو عدم التعرف على الوجوه السوداء كبشر.

وليس سراً أيضاً أن روايات القصص التاريخية تميل إلى إبراز دور الرجال، مع حذف أدوار النساء من قصص الماضي.

لكن يبدو أن غوغل حاولت جاهدة حل مشكلة كل هذا التحيز البشري الفوضوي من خلال تعليمات برنامج "جيميني إيه أي" بعدم تقديم هذه الافتراضات، والنتيجة جاءت عكسية، لأن تاريخ البشرية وثقافته ليسا بهذه البساطة، فهناك فروق دقيقة نعرفها بشكل غريزي، بينما لا تعرفها الآلات.

إذا ما لم تقم ببرمجة الذكاء الاصطناعي على وجه التحديد ليعرف - على سبيل المثال - أن النازيين والآباء المؤسسين لم يكونوا من السود، فلن يقوم بافتراض العكس.

قال ديميس هاسابيس، المؤسس المشارك لشركة "ديب مايند"، وهي شركة ذكاء اصطناعي استحوذت عليها غوغل مؤخراً، إن إصلاح مولد الصور سيستغرق أسابيع، لكن خبراء الذكاء الاصطناعي الآخرين شككوا في إمكانية تطبيق ذلك.

وقالت الدكتورة ساشا لوتشيوني، عالمة الأبحاث في "هاغينغ فيس" إنه "لا يوجد حل سهل حقاً، لأنه في معظم الأحيان لا توجد إجابة واحدة للأسئلة المطروحة"، وتضيف أن "الخبراء في الذكاء الاصطناعي عملوا على إيجاد طرق ممكنة لمعالجة هذه المشكلة لسنوات عديدة".

وأوضحت أن أحد الحلول يمكن أن يتضمن مطالبة المستخدمين بإدخال متطلباتهم، مثل "ما مدى التنوع الذي تريد أن تكون عليه صورتك؟" ولكن من الواضح أن هذا في حد ذاته تحدّ كبير.

وقالت لوتشيوني إنه "من الغرور بعض الشيء أن تقول غوغل إنها ستصلح المشكلة في غضون أسابيع قليلة، لكن سيتعين عليها في النهاية أن تحل المشكلة".

وقال البروفيسور آلان وودوارد، عالم الكمبيوتر في جامعة ساري، إن المشكلة من المرجح أن تكون "متجذرة بعمق" في كل من بيانات التدريب والخوارزميات المتداخلة - وسيكون من الصعب حلها.

وأوضح وودوارد "ما يحدث هو سبب للحاجة إلى وجود إنسان في الحلقة، لإدارة نظام يتم الاعتماد على مخرجاته كحقيقة مطلقة".

سلوك "بارد"

منذ اللحظة التي أطلقت فيها شركة غوغل برنامج "جيميني إيه أي"، والذي كان يُعرف آنذاك باسم "بارد"، كانت الشركة متوترة للغاية بشأن هذا الأمر. على الرغم من النجاح الهائل الذي حققته منافستها "تشات جي بي تي"، إلا أنها كانت واحدة من أكثر عمليات الإطلاق "الصامتة"على الإطلاق.

وكنت أنا فقط، في مكالمة عبر تطبيق "زووم"، مع اثنين من المسؤولين التنفيذيين في غوغل الذين كانوا حريصين على إبقاء موضوع إطلاق البرنامج على نطاق ضيق قدر الإمكان .

وحتى ذلك سار بشكل خاطئ، فقد تبين أن البرنامج أجاب بشكل غير صحيح على سؤال حول الفضاء، والذي استند فيه إلى المعلومات الخاصة به.

ويبدو أن بقية قطاع التكنولوجيا مرتبك جداً مما يحدث، والجميع في صراع مع ذات القضية.

في مقابلة مع روزي كامبل، مديرة السياسات في "أوبن إيه أي" منشئ "تشات جي بي تي"، في وقت سابق من هذا الشهر، قالت إنه حتى بعد تقليل احتمال وقوع "التحيز" في "أوبن إيه أي"، إلا أن تصحيحه قد يكون أمراً صعباً - ويتطلب مدخلات بشرية.

على الورق، تتمتع شركة غوغل بتقدّم كبير في سباق الذكاء الاصطناعي. فهي تصنع وتزود شرائح الذكاء الاصطناعي الخاصة بها، وتمتلك شبكتها السحابية الخاصة (ضرورية لمعالجة الذكاء الاصطناعي)، ولديها إمكانية الوصول إلى كميات كبيرة من البيانات، ولديها أيضاً قاعدة مستخدمين ضخمة، وتوظف مواهب عالية المستوى في مجال الذكاء الاصطناعي، ويحظى عملها في هذا المجال بتقدير عالمي.

وكما يقول أحد كبار المسؤولين التنفيذيين من شركة تكنولوجية منافسة، إن مشاهدة أخطاء برنامج "جيميني إيه أي" تبدو كمشاهدة هزيمة منتزعة من بين فكي النصر.

- عشرون عاماً على ظهور فيسبوك: أربع طرق غيَّرت بها المنصة العالم

- كيف يساعد الذكاء الاصطناعي صناعة السجاد التقليدية الهندية في كشمير؟

التعليقات